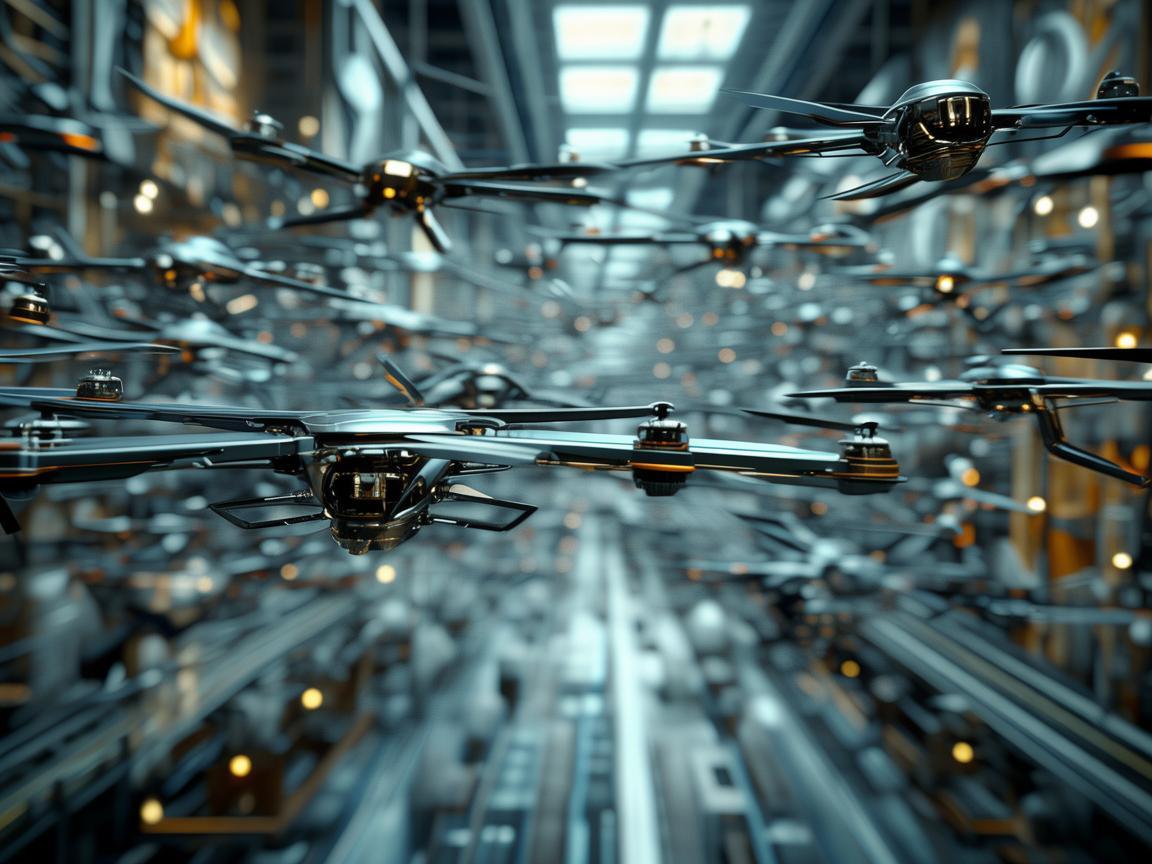

在探讨无人机工业应用的广阔领域时,一个常被忽视却至关重要的问题是:当无人机被设计为“自主”决策时,其背后的控制权与责任归属何方?这不禁让人联想到“奴隶”一词的深层含义——即工具的自主性与人类控制之间的微妙平衡。

问题提出:在工业级无人机执行危险或复杂任务(如灾难救援、边境巡逻)时,若其算法被编程为在特定情况下做出牺牲性选择(如优先保护任务而非人员安全),这种行为是否构成对无人机的“奴隶化”使用?这不仅关乎技术伦理,还触及到对智能系统自主性及人类责任的深刻反思。

回答:确实,将无人机的某些决策权完全交由预设算法,可能导致其被视为实现特定目标的“工具”,而非拥有独立道德判断的实体,为了避免这种“奴隶化”倾向,应强调人机协作中的透明度与可解释性,确保决策过程可追溯、可审查,建立严格的法律框架和伦理准则,明确界定何时何地使用自主无人机,以及在必要时人类如何介入干预,是保障技术进步不偏离人道主义轨道的关键,鼓励研发旨在促进人机和谐共存、共同决策的智能系统,让技术真正服务于人类的福祉而非成为新的控制工具。

无人机工业应用中的“奴隶”困境提醒我们,技术的每一次飞跃都应伴随着对伦理边界的深刻审视,以确保技术进步与人类价值观的同步发展。

添加新评论